Tras una tediosa etapa de recopilación y organización de información, se pone fin a este proyecto fin de carrera. Su objetivo, continuando en la linea del pasado artículo, consiste en estudiar si los últimos avances tecnológicos permitirían que todo aquel que sufre de poca o ninguna visión pueda disfrutar de una mayor autonomía al desplazarse por la ciudad o en interiores.

El documento impreso incluye en primer lugar un estudio del perfil de usuario, tratando cuestiones como cuál es el número de usuarios potenciales, qué necesitan, cuáles son sus circunstancias (empleo, educación, nivel de ingresos, etc.) o cómo se manejan con las nuevas tecnologías. En dicho estudio y a lo largo del documento se recomienda aprovechar la creciente tendencia a utilizar teléfonos inteligentes en el diseño de futuros dispositivos; proyectos clásicos como The vOICe cuentan con su propia aplicación móvil gratuita.

En segundo lugar, se ahonda en la trayectoria I+D+i de los sistemas de navegación para personas con discapacidad visual. No han sido pocas las soluciones propuestas hasta la fecha, empezando por los trabajos de Paul Bach-y-Rita, C. C. Collins et alii en el ámbito de la sustitución sensorial; las propuestas simultáneas de Collins y Jack M. Loomis acerca de recurrir al GPS para guiar a invidentes; incluso la progresiva introducción de elementos propios de la realidad aumentada, hasta sistemas más recientes que trabajan con visión artificial (Seeing AI), redes de balizas BLE (Bluetooth Low Energy, ver WayFindr), etc.

Una vez alcanzado el punto de desarrollo actual, se evalúan una lista de campos tecnológicos con amplia financiación como posibles elementos críticos en el desarrollo de futuros sistemas; a saber: realidad virtual y aumentada, wearables, conducción autónoma, drones, y otros tantos relacionados con el nuevo paradigma de las telecomunicaciones (5G, IoT, WSN, … ).

Pasados estos puntos, se propone una nueva arquitectura de sistema fundamentada en la visión artificial y las nuevas infraestructuras de telecomunicaciones, guiados por los proyectos previos, aceptación de los dispositivos desarrollados, y las necesidades y características de los futuros usuarios.

Uno de los elementos clave en dicha arquitectura consiste en la interfaz de usuario, ya que aun disponiendo de toda la información útil sobre el entorno, discernir qué necesita conocer el usuario y cómo comunicárselo de forma óptima constituye uno de los principales problemas de este tipo de sistemas.

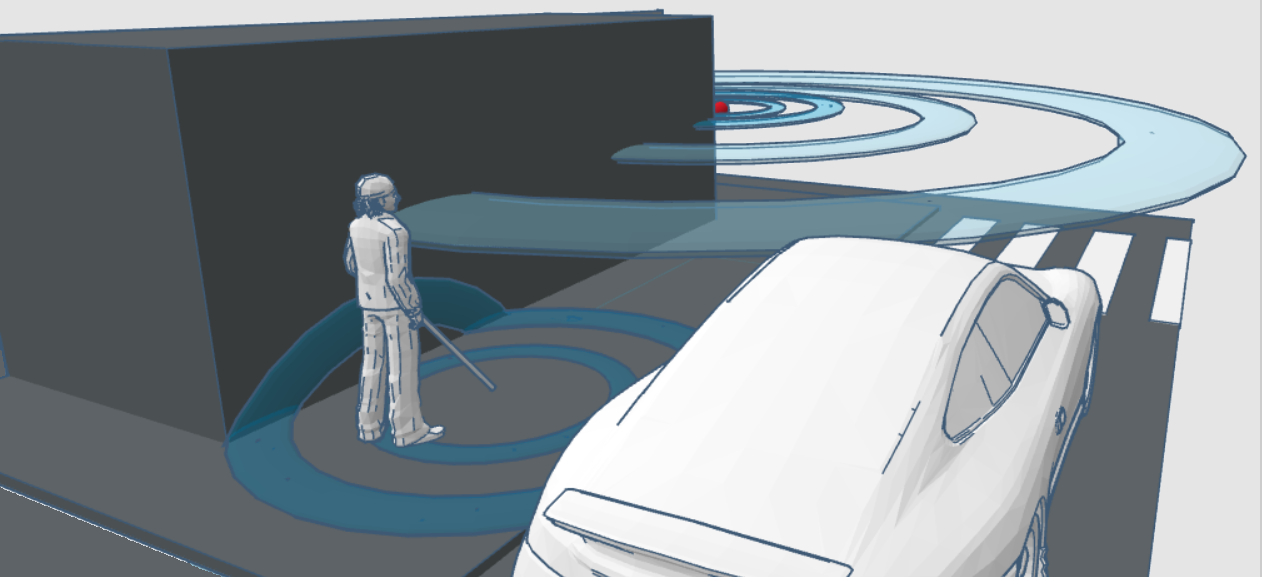

La solución propuesta es vieja, pero en un nuevo contexto técnico: la realidad aumentada. A día de hoy se podrían aprovechar tecnologías de este campo, con Tango (Google) o Microsoft Hololens como ejemplos característicos, para introducir en el entorno elementos virtuales perceptibles por el oído (imagen arriba) o por el tacto que describan el entorno al usuario de forma intuitiva.

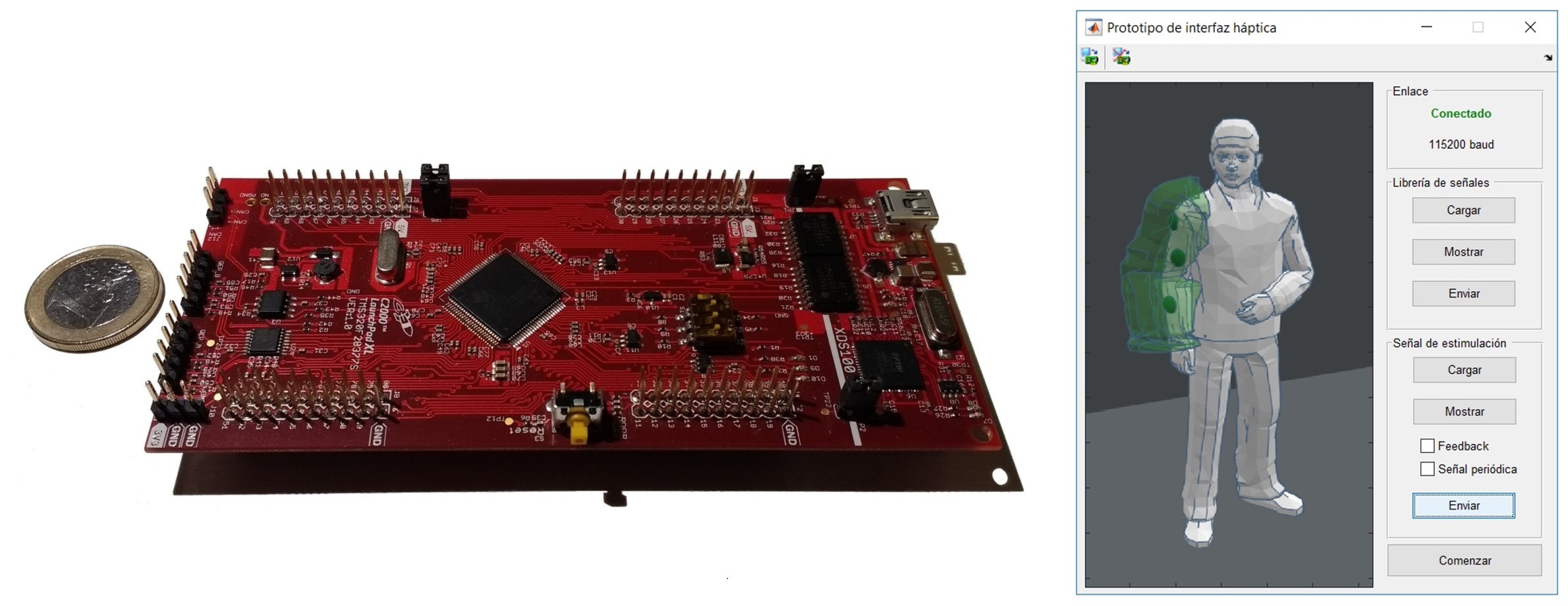

Sin embargo, las interfaces hápticas (tacto) actuales son muy pobres como para implementar soluciones de este tipo. Es por ello que se ha diseñado una plataforma de pruebas para la estimulación nerviosa transcutánea sobre la placa de desarrollo F28377S Launchpad de Texas Instrument (imagen abajo), y una interfaz con la plataforma Matlab, de cara a continuar en otra de las viejas soluciones: la interfaz electrotáctil.

Un ejemplo de dispositivo comercial que emplea esta tecnología es el BrainPort v100, fruto (en parte) de los trabajos de Paul Bach-y-Rita et alii; pero extender el campo de acción de la interfaz electrotáctil a zonas del cuerpo más allá de la lengua conlleva complicaciones aún sin resolver.

El objetivo del dispositivo desarrollado es, por tanto, trabajar con técnicas recientes orientadas a resolver este problema, y estudiar si es posible implementar una interfaz electrotáctil que “envuelva” al usuario. Se prevé que este tipo de interfaz permitiría simular percepciones útiles para guiar al usuario de forma eficiente, tales como el contacto con objetos virtuales (ejemplo en la figura de abajo, derecha).